In questi mesi, quando si parla di «AI che traduce da sola», le reazioni sono polarizzate: ci sono più entusiasmi o più paure? Il titolo provocatorio “Chi ha paura dell’AI?” vuole proprio stimolare la riflessione su ciò che c’è effettivamente in gioco, oltre l’illusione della “traduzione gratis e perfetta”.

- Le grandi opportunità (e perché l’AI non va demonizzata)

- Velocità e produttività: per testi ripetitivi, volumi elevati, contenuti “di basso rischio” (schede tecniche, FAQ, descrizioni generiche) l’uso di modelli di traduzione automatica o generazione testuale AI può ridurre tempi e costi.

- Accessibilità e democratizzazione linguistica: l’AI abbassa le barriere linguistiche, permettendo anche a chi non ha budget elevati di ottenere una “prima bozza” tradotta.

- Supporto agli esperti umani: un buon workflow combina AI + revisione umana (post-editing), sfruttando la potenza dell’AI per il grosso lavoro e l’occhio (e l’orecchio) esperto per rifinire nuance, registro, contesto.

- Riscontri e apprendimento: i modelli AI migliorano continuamente (finestre di training, feedback), e un uso ben guidato può alimentare una base di conoscenza a vantaggio del cliente e del fornitore.

Tuttavia, queste opportunità sono reali solo se l’AI non viene usata “alla cieca”. Ed è qui che entriamo nella parte più pericolosa del discorso.

- Quando l’AI traduce (o scrive) troppo — i rischi maggiori

Ecco i principali nodi critici che emergono quando l’AI viene impiegata senza adeguati controlli:

- Allucinazioni / “hallucinations”

L’AI può generare citazioni, fonti, fatti inventati presentandoli come reali. Questo fenomeno, ormai ben documentato, è chiamato “hallucination” dei modelli linguistici.

➤ È proprio quel che è successo al reportage di Deloitte: il documento conteneva citazioni fabbricate e riferimenti accademici inesistenti, oltre che una citazione inventata da una sentenza federale. - Errori di contesto, ambiguità e perdita di nuance

L’AI fatica a cogliere sarcasmo, doppi sensi, espressioni idiomatiche, giochi di parole, cultura locale, tono aziendale.

In testi tecnici, legali o scientifici, una parola tradotta male o un termine ambiguo può cambiare radicalmente il senso e avere conseguenze gravi. - Bias impliciti e pregiudizi

I modelli AI sono allenati su grandi corpora testuali che già contengono bias culturali, stereotipi di genere, linguistici ed etnici. In traduzione, questi pregiudizi si manifestano nel rendere generi, ruoli, pronomi in modo stereotipato o scorretto. - Sicurezza, riservatezza e gestione dati

Quando si caricano testi sensibili su sistemi AI (soprattutto gratuiti o cloud pubblici), esiste il rischio che i dati vengano memorizzati, analizzati o utilizzati per training futuri.

In ambito giuridico, sanitario, contrattuale, queste fughe di dati possono configurare responsabilità legali o violazioni normative. - Dipendenza tecnologica e svalutazione del tocco umano

Se un’azienda si affida completamente all’AI, perde la capacità critica di intervenire e il contatto con lo stile, il tono, la sensibilità culturale locale. Un’eccessiva automatizzazione può generare contenuti “piatti”, omogenei, freddi. - Rischio reputazionale e legale

Quando un contenuto tradotto male finisce online, in un comunicato stampa o in un contratto ufficiale, l’errore ha una visibilità elevata. La fiducia del pubblico, dei clienti, dei partner può essere compromessa. E in casi estremi si possono applicare responsabilità legali per errori contrattuali, dichiarazioni false o violazioni normative.

- Il caso Deloitte Australia: un monito concreto

Il 6 ottobre 2025 è emerso che Deloitte Australia ha accettato di rimborsare parzialmente il governo, dopo che un rapporto di 440.000 AUD conteneva errori gravi — tra cui citazioni inventate e fonti inesistenti — collegabili a parti generate con AI (in particolare Azure OpenAI) nel documento.

Il Rapporto originario è stato revisionato, e Deloitte ha dichiarato che l’uso di AI non avrebbe influenzato i risultati sostanziali del rapporto, pur riconoscendo che rimanevano errori nelle citazioni e nei riferimenti.

Il clamoroso episodio mette in luce come anche realtà molto strutturate e con processo di revisione possano inciampare quando l’AI è usata con superficialità.

Questo caso è particolarmente utile per chi vuole comunicare con i potenziali clienti: non parliamo più di “paure astratte”, ma di danni reali — reputazionali, finanziari, contrattuali.

- Best practice per un uso responsabile dell’AI in traduzione e generazione

Per evitare che l’AI diventi una trappola, ecco alcune linee guida che InnovaLang consiglia (e, idealmente, applica internamente):

| Fase | Raccomandazione |

| Valutare il rischio | Identificare il livello di criticità del testo: basso (FAQ, contenuti generici), medio (marketing, sito web) o alto (documenti legali, contratti, materiale regolatorio). |

| Selezione della tecnologia | Utilizzare modelli professionali con capacità di personalizzazione, glossari aziendali, memoria terminologica. Non affidarsi a tool “free” generici che non garantiscono riservatezza. |

| Ibrido AI + umano | Usare l’AI solo come “prima bozza”, affidando la revisione (post-editing o editing completo) a traduttori professionisti con esperienza. |

| Verifica contestuale | Controlli incrociati sulle referenze, fonti, citazioni; verifica semantica del contesto e coerenza stilistica. |

| Glossari e memorie terminologiche | Integrare risorse aziendali che vincolino l’AI a rispettare il tono, il branding, i termini chiave. |

| Controllo qualità finale | Checklist umana obbligatoria: terminologia, contesto, legalità, riferimenti bibliografici, omissioni, coerenza. |

| Politiche di riservatezza e governance | Contratti chiari con obblighi di riservatezza, NDA, protocolli di trattamento dati e logiche non uscite per training esterno. |

| Monitoraggio post-pubblicazione | Analisi feedback utenti, segnalazioni errori, tracking di eventuali imprecisioni per aggiornare i processi interni. |

In definitiva, l’AI non va demonizzata: è uno strumento potente, ma non autonomo quando si parla di contenuti che contano davvero.

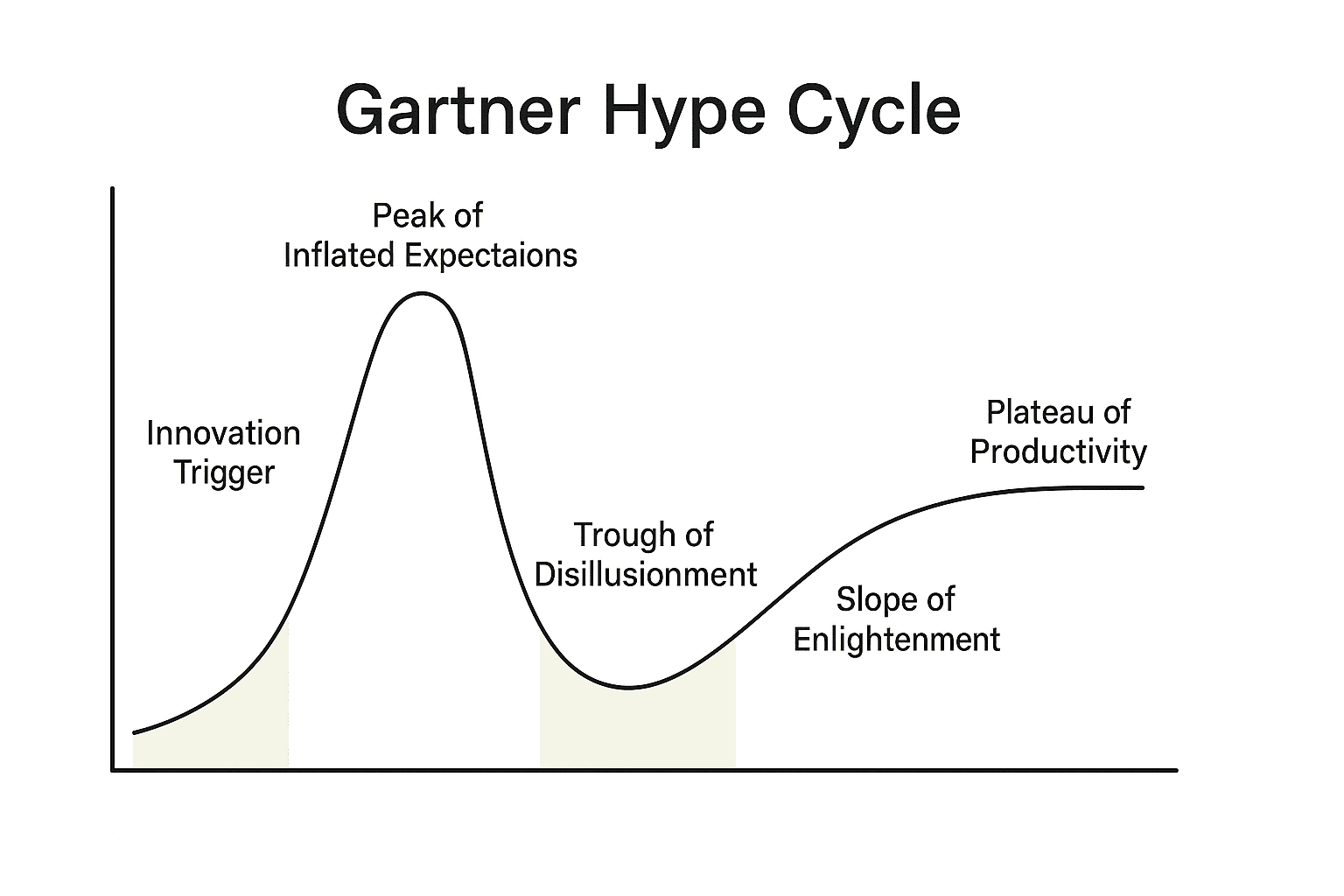

Per approfondimenti sul ciclo dell’esagerazione e la AI, vedi anche questo nostro recente articolo su come si evolve l’entusiasmo nei confronti di una nuova tecnologia come questa!

- Messaggio finale (e call to action per i potenziali clienti)

Se l’AI può sembrare una scorciatoia allettante, la verità è che senza guida qualificata si corre un rischio concreto: errori nascosti, “allucinazioni”, perdita di fiducia e danni reputazionali difficili da recuperare. Aziende e professionisti seri devono chiedersi: “Chi corregge l’AI?”

InnovaLang propone servizi integrati: traduzione assistita da AI, ma con supervisione umana da parte di traduttori esperti, controllo qualità e garanzia di coerenza terminologica. Solo così si può davvero sfruttare l’AI come acceleratore, anziché esserne vittima.

Per una consulenza gratuita o un audit sul modo in cui la tua azienda usa (o rischia di usare male) l’AI linguistica, contattaci subito.